今回はVisual Studio CodeにAI Toolkit for Visual Studio Codeをインストールし、Ollamaのフロントエンドとして使用する方法を紹介します。

AIにプログラムを書かせるところまでしなくても

世間ではAI

そんなときに検討したいのが、Visual Studio Code

たったそれだけといえばそれまでですが、別アプリに切り替えることによって思考が途切れることを避けることができるのは、大きなメリットといえます。

使用したバージョン

今回使用したバージョンは、Ubuntu 24.

GPUはNVIDIA GeForce RTX 3060としました。ドライバーのバージョンは、第869回と同じく550です。

Ollamaのセットアップ

Ollamaのセットアップ方法はいくつかありますが、オーソドックスにインストールスクリプトを実行する方法にします。OllamaはGo言語で書かれており、依存関係が極めてシンプルでアンインストールも簡単であり、インストールスクリプトを使用することによるデメリットは多くありません。

端末から次のコマンドを実行します。

$ sudo apt install curl $ curl -fsSL https://ollama.com/install.sh | sh

しばらく待っていれば、インストールが完了します。またその時点で起動もしています。

試してはいませんが、AMDのGPUを使用している場合は追加で次のコマンドを実行します。

$ curl -L https://ollama.com/download/ollama-linux-amd64-rocm.tgz -o ollama-linux-amd64-rocm.tgz $ sudo tar -C /usr -xzf ollama-linux-amd64-rocm.tgz

Ollamaの実行にはモデルも必要なのでダウンロードします。モデルはリストから見つけるのが簡単です。実はここに表示されているものがすべてというわけではありませんが、よほど特定のモデルを使用したいということがなければ、ここにあるポピュラーなものから探すといいでしょう。

今回はGeForce RTX 3060でVRAMは12GBなので、これにあったモデルをインストールします。執筆段階で一番のお気に入りはMicrosoftのPhi-4なので、これにします。VRAMが16GB程度までであればおすすめです。VRAMが4GB程度であれば候補となるのはPhi4-miniですが、やはり使用感は厳しいです。

他にもDeepCoderやGemma 3などもインストールしています。

インストール方法は、モデルのページに書かれているコマンド、具体的には

$ ollama run phi4

ですが、これだと実行してしまうので、ダウンロードするだけであれば

$ ollama pull phi4

とするのがおすすめです。

もちろんモデルは複数インストールでき、切り替えも簡単なので

AI Toolkitのセットアップ

VS Codeのインストール方法は解説しませんが、snapパッケージではなくDebianパッケージ版を使用します。

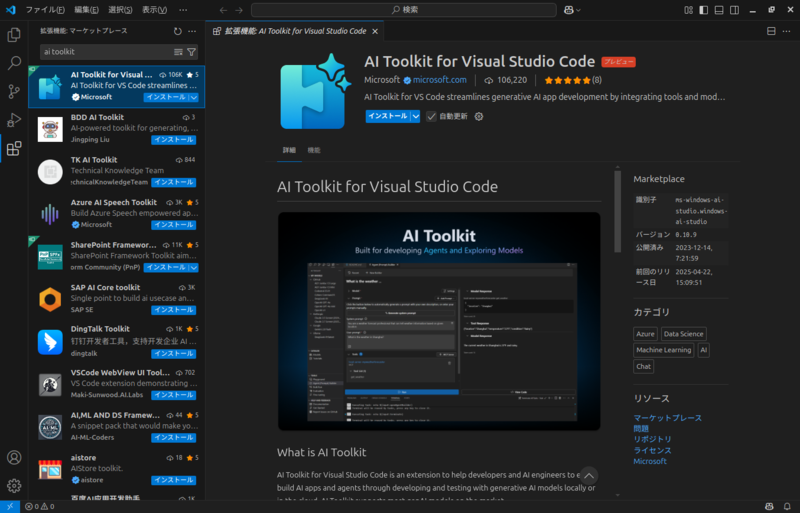

拡張機能は通常と同じく、

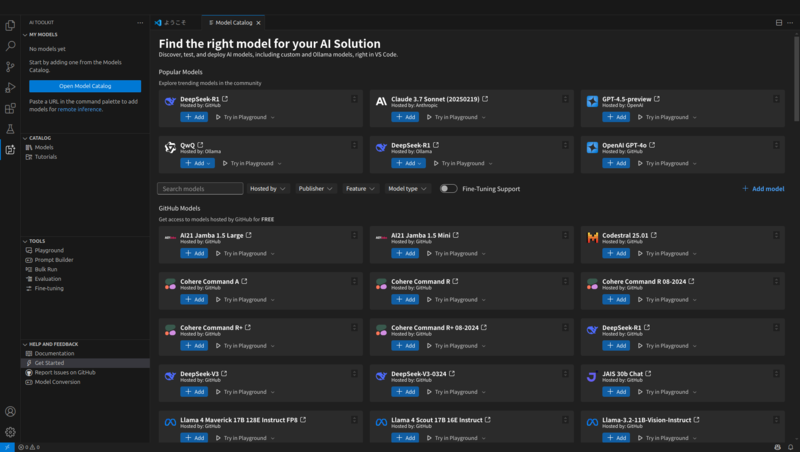

AI Toolkitをインストールすると、左端のアクティビティバーに

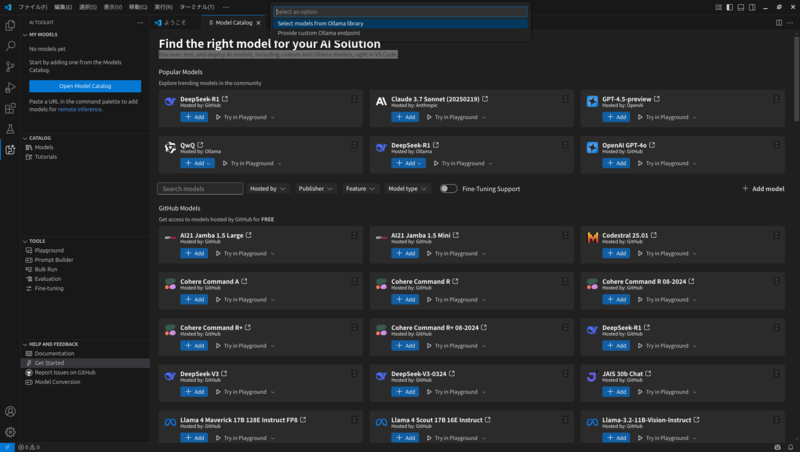

ここからは実際にOllamaで使用するモデルを選択します。図2の中央右にある

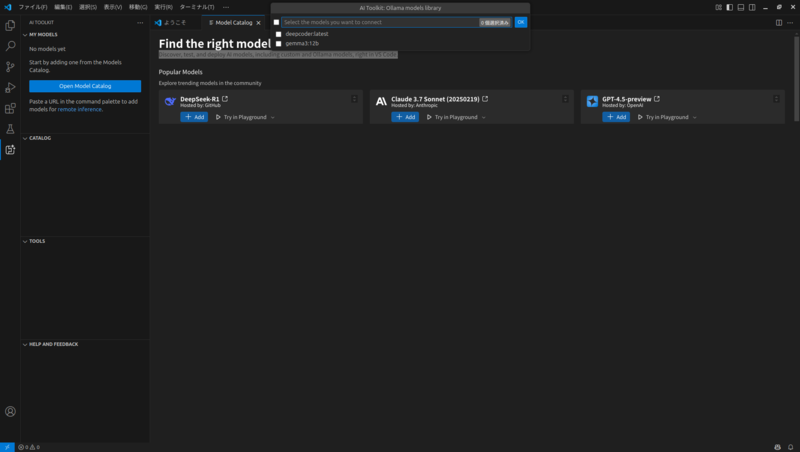

続けてインストールされているモデルが表示されるので、使用したいモデルをクリックして

これで準備が整いました。

実際に使用してみる

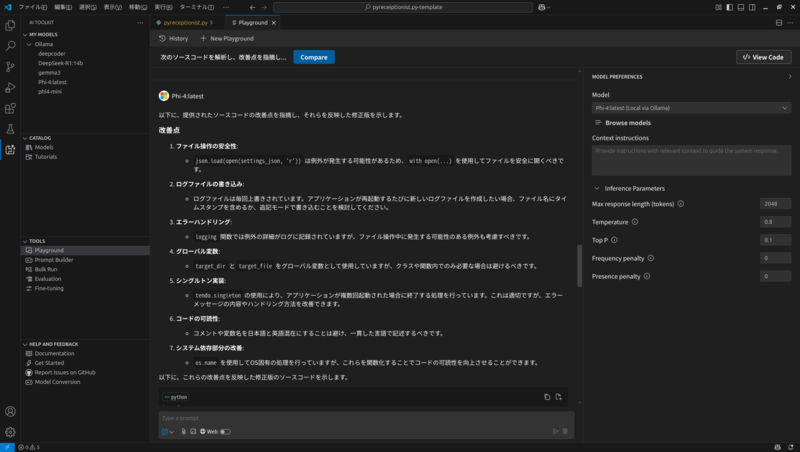

では実際に使用してみましょう。ここで提示するサンプルはなかなかに難しいですが、筆者が実際に書いたPythonスクリプトに対して改善できるところがあるかどうかと、実際に改善した変更点をスクリプトに反映してもらうことにしました。

左端のアクティビティバーにある

そもそもあまり長くないスクリプトであり、GeForce RTX 3060でも数秒

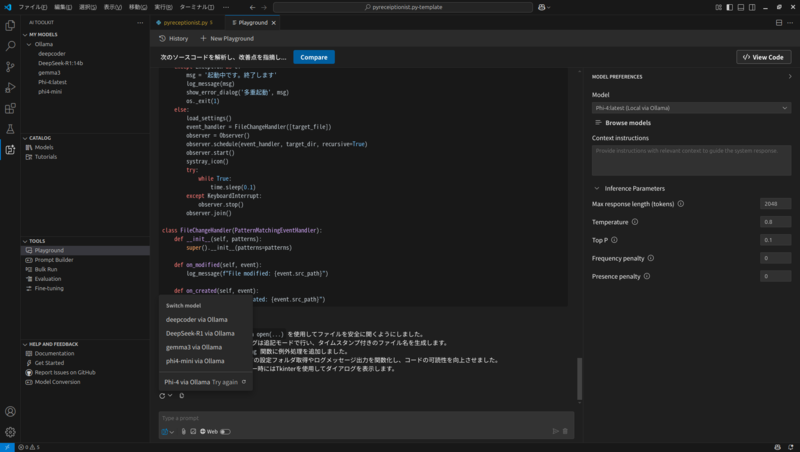

Playgroundの便利なところは同じプロンプトで別のモデルへの問い合わせが簡単にできることです。プロンプト入力欄の左上にある再読込ボタンをクリックしてモデルを変更すると、それだけで問い合わせが実行されます

ちょっとこの結果は気に入らないな、ということがあったら、即座に別解を求められるのはとても便利であり、AIでやってほしいことの1つでしょう。